Nun, da das Semester vorbei ist, möchte ich den Blog mit einem kurzen, persönlichen Fazit abschliessen. Falls jemand einen inhaltlichen Überblick über das Thema Ubiquitous Computing wünscht, soll er sich den Folien meines Vortrages widmen.

Auf die Grundfragen des Moduls Informationsgesellschaft, -ethik und -politik (IGEP) gebe ich nun kurz und knapp Antwort.

- Ist dies wirklich eine neue Ära? Ja, die Vernetzung und Digitalisierung läutete eine neue Ära ein.

- Wenn ja, wodurch zeichnet sie sich technisch aus? Durch Vernetzung, Digitalisierung, Informatisierung, Miniaturisierung, etc.

- Welches sind ihre wirtschaftlichen Phänomene? Globalisierung, Rationalisierung, Integration der realen Welt in die digitale Welt, etc.

- Welche gesellschaftlichen Auswirkungen hat sie? Information Overload, Datenschutzproblematik, Digital Divide, etc.

- Wer sind die Gewinner und Verlierer? Gewinner ist die New Economy (jedenfalls diejenigen, welche das Platzen der Blase überlebt haben). Zu den Verlierern zählen datenschutzbewusste Konsumenten und die informationelle Selbstbestimmung.

- Welche neuen Rahmenbedingungen müssen wir stellen (Ethik)? Datenschutzrichtlinien müssen auf der Höhe der technischen Entwicklung gehalten werden. Das Recht auf informationelle Selbstbestimmung muss gewahrt und verteidigt werden. Den Digital Devide gilt es zu bekämpfen.

Hiermit ziehe ich einen Schlussstrich unter den doch eher arbeitsintensiven Lernnachweis „e-Portfolio“. Interessant und gewinnbringend war es vor allem, einmal selber einen Blog zu betreiben. Dieses Soft-Skill setze ich nun auch persönlich ein. Diejenigen, die mich kennen, wissen welchen Blog ich betreibe. Alle anderen sollen für einmal mit meinem persönlichen YouTube-Favoriten vertröstet werden:

„Ein witziges, gut gemachtes Video; doch bleibt einem schnell das Lachen im Halse stecken, gedenk der Möglichkeiten, die Google tatsächlich hätte… Die Frage nach der Macht, die Information verleiht wird im 21. Jahrhundert zu völlig neuen Dimensionen gelangen. Noch nie waren die Auswirkungen so spürbar, so nah, so konkret und so gefährlich.“

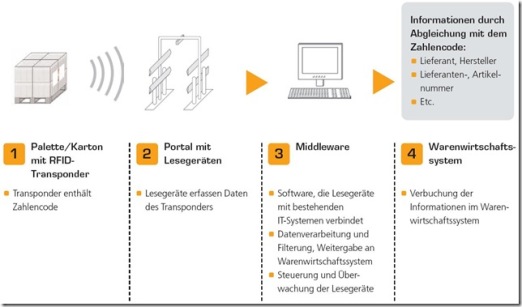

Es handelt sich dabei um einen winzigen Computer-Chip, der mit einer Antenne ausgestattet ist. Integriert sind Chip und Antenne meist in ein Trägerobjekt. Dabei kann es sich um Kreditkarten, Ausweise, Produktetiketten, Fahrzeuge, Tiere oder sogar Menschen handeln.

Es handelt sich dabei um einen winzigen Computer-Chip, der mit einer Antenne ausgestattet ist. Integriert sind Chip und Antenne meist in ein Trägerobjekt. Dabei kann es sich um Kreditkarten, Ausweise, Produktetiketten, Fahrzeuge, Tiere oder sogar Menschen handeln.

Schöpfer des Begriffes Ubiquitous Computing ist Mark Weiser (1952-1999). Im Jahre 1988

Schöpfer des Begriffes Ubiquitous Computing ist Mark Weiser (1952-1999). Im Jahre 1988

Beiträge

Beiträge

Neueste Kommentare